meng shao

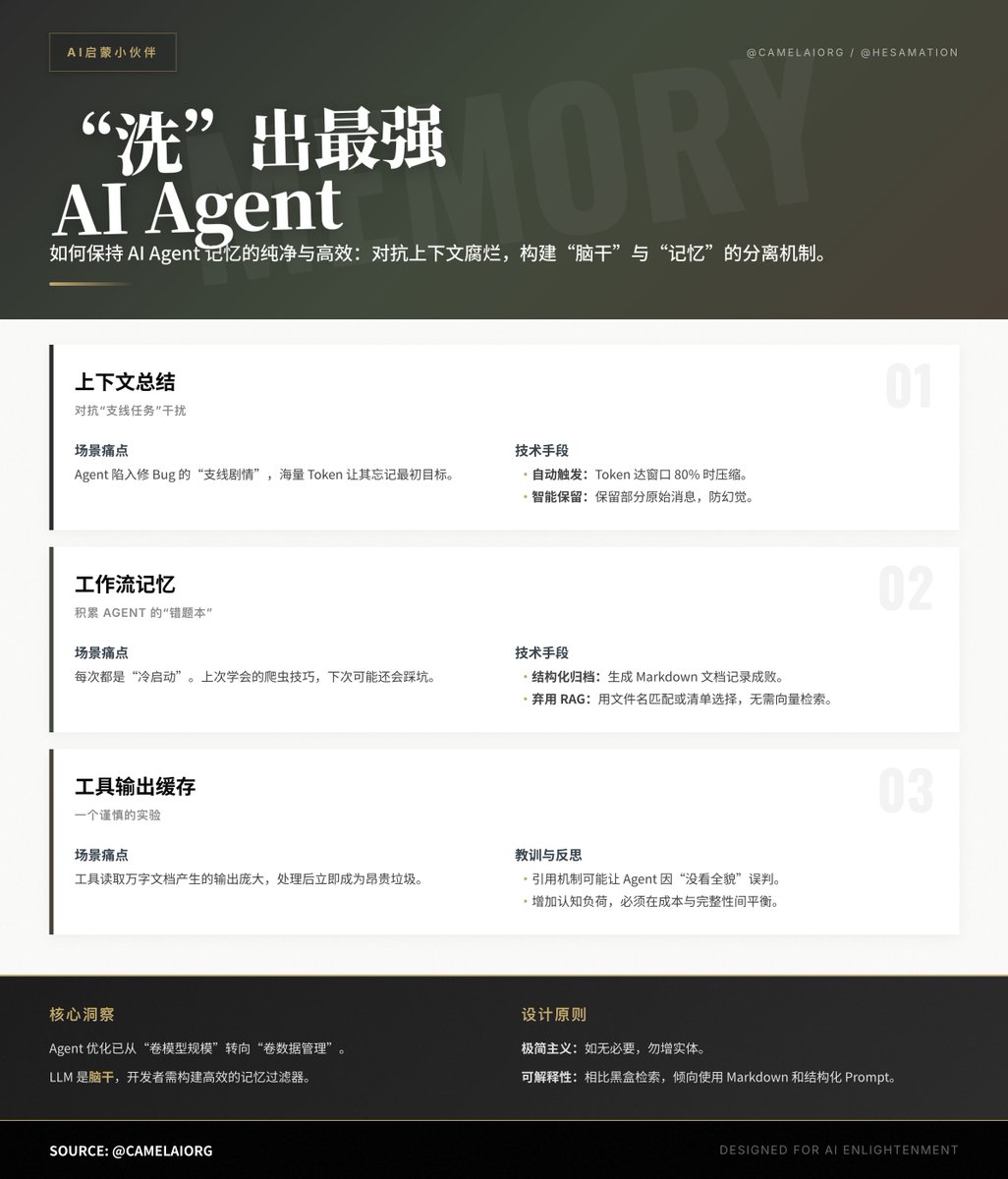

@shao__meng · 5天前“洗”出最强 AI Agent:如何保持 AI Agent 记忆的纯净与高效

来自 @CamelAIOrg 团队 @Hesamation 的文章,他表示:AI Agent 的智商很大程度上取决于它的“上下文工程”,Agent 变笨通常是因为上下文出现了“腐烂”,冗余信息淹没了关键指令,CAMEL 团队提出的三种核心技术及其背后的实战思考。

1. 上下文总结:对抗“支线任务”的干扰

场景痛点:当你让 Agent 写个代码,它可能会为了修一个数据库的小 Bug 而陷入长达 10 分钟的搜索。这段“支线剧情”会产生海量 Token,让 Agent 忘记最初的任务目标。

技术手段:

· 自动触发:当 Token 使用率达到窗口的 80% 时自动压缩。

· 智能保留:在总结时,CAMEL 会特意保留一小部分原始用户消息。这是为了防止 LLM 在总结时产生幻觉或遗漏细节,确保“最高指示”不走样。

价值:将 Agent 从细节泥潭中拉出来,重新聚焦于全局目标。

2. 工作流记忆:让 Agent 积累“错题本”

场景痛点:Agent 每次处理任务都是“冷启动”。如果它上次费了很大劲才学会如何爬取某个反爬严厉的网站,下次遇到同样任务,它可能还会再踩一遍坑。

技术手段:

· 结构化归档:任务完成后,自动生成一份 Markdown 文档。包含:任务描述、成功的操作步骤、使用的工具、失败记录及修复策略。

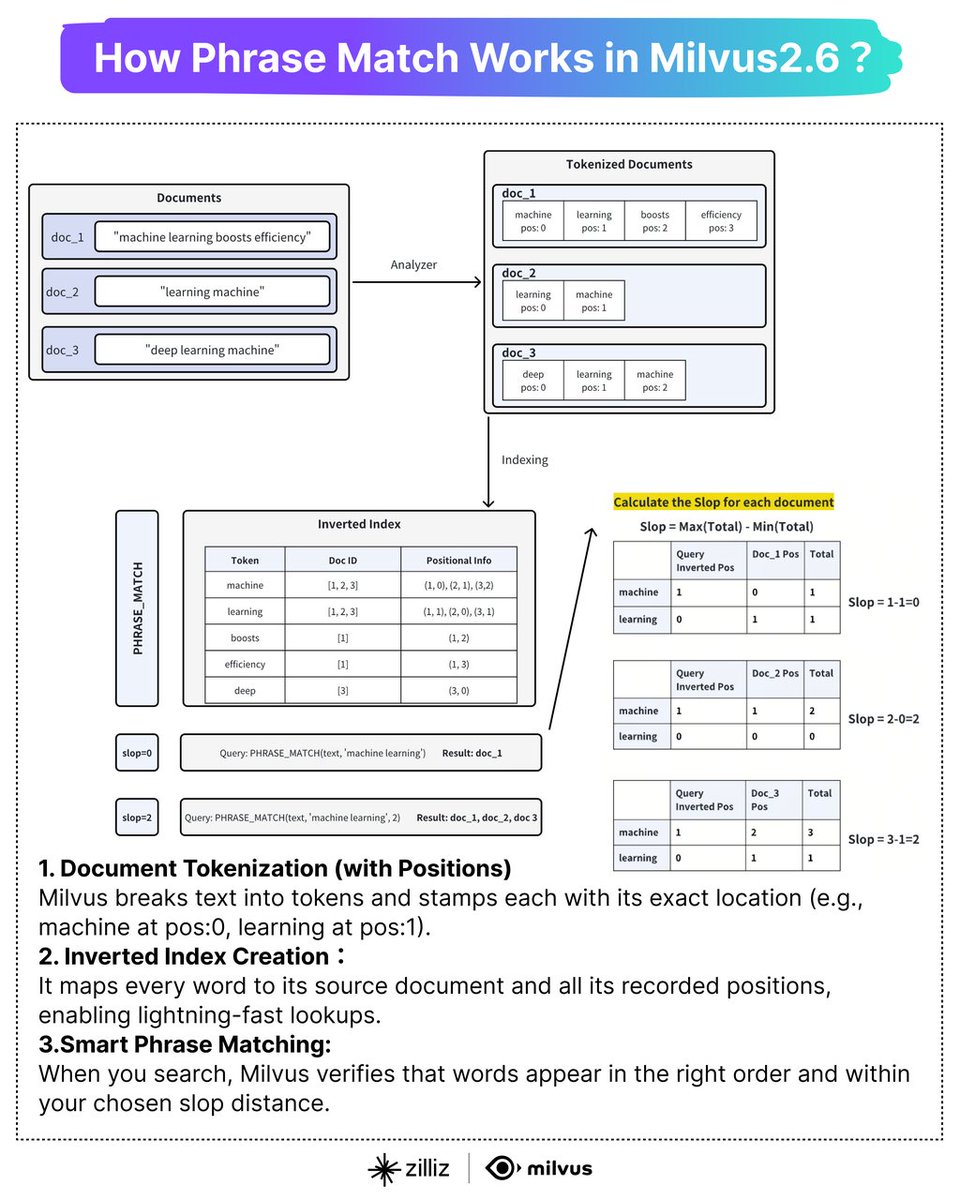

· 弃用 RAG:这是一个非常有趣的观点。作者认为对于工作流记忆,不需要复杂的向量检索。通过文件名匹配、标签筛选或让 Agent 在一小份清单中自主选择即可。

价值:将“过程性经验”转化为“确定性指令”,显著提升 Agent 在重复性任务中的成功率。

3. 工具输出缓存:一个谨慎的实验

场景痛点:工具调用(如读取万字文档)产生的输出极其庞大。这些数据可能只在被处理的那一秒有用,之后就成了昂贵的垃圾。

技术手段:

· 引用机制:如果输出超过 2000 字符,就将其存入磁盘,在对话中只留下一个 ID、简短预览和检索指令。

反思与教训:

· CAMEL 团队在实践后一度撤回了此功能。因为他们发现,如果预览信息不足,Agent 可能会因为“没看到全貌”而做出错误判断。

· 这增加了 Agent 的认知负荷:它必须自己判断什么时候该去“提取旧文件”,什么时候只看预览就行。

启示:过度追求 Token 效率可能会损害 Agent 的推理能力,内存清理必须在“节省成本”与“信息完整”之间走钢丝。

核心解读与总结

文章的专业洞察在于:Agent 的性能优化已经从“卷模型规模”转向了“卷数据管理”。

· 脑干与记忆的分离:LLM 是脑干,而开发者需要构建一个高效的记忆过滤器。

· 极简主义原则:最好的上下文工程是“如无必要,勿增实体”。

· 可解释性:相比于全黑盒的记忆检索,CAMEL 倾向于使用 Markdown、标签和结构化 Prompt,让开发者能看懂 Agent 到底记住了什么。

博客地址

camel-ai.org/blogs/brainwas…

ℏεsam

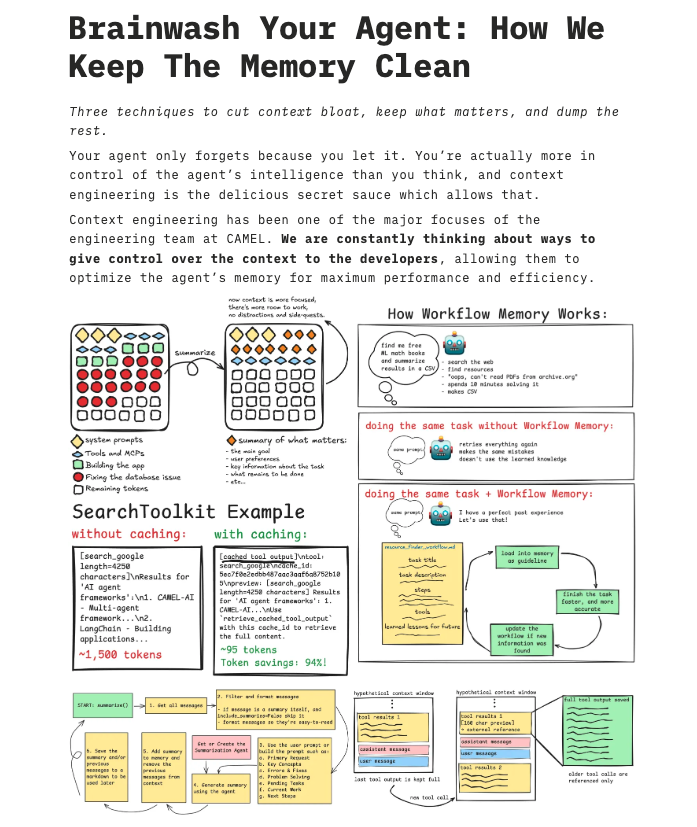

@Hesamation · 2个月前brainwash your agents.

context engineering doesn't have to be hard, there are so many low-hanging fruits. just keep the memory a holy place and drop the bs messages

I just wrote a blog post on how we do it at @CamelAIOrg. these are simple to implement, must-have techniques for apps that use agents, which can optimize the accuracy and the cost without crazy code changes.

🎁 BONUS: I created a number of bite-sized issues that you can get on right now and start your open-source arc. just open a PR, or help review one.

read here:shorturl.at/zyCv7F

18

136

1,069

7.6万

1

19

66

67

22